欢迎来到noYes游戏王国

网站导航

在上一篇文章中,小编为您详细介绍了关于《薅游戏平台羊毛的100种方法_Steam》相关知识。本篇中小编将再为您讲解标题人类一败涂地?DeepMind推出Agent57,在所有雅达利游戏上超越人类玩家_智能。

原标题:人类一败涂地?DeepMind推出Agent57,在所有雅达利游戏上超越人类玩家

让单个智能体完成尽可能多的任务是 DeepMind 一直以来的研究目标,也被该公司视为迈向通用人工智能的必经之路。去年,DeepMind 推出的 MuZero 在 51 款雅达利游戏中实现了超越人类的表现。时隔数月,DeepMind 在这一方向上更进一步,在 57 款雅达利游戏中全面超越人类,在这一领域尚属首次。

DeepMind 在最新发布的预印本论文和博客中介绍了这一进展。他们构建了一个名为 Agent57 的智能体,该智能体在街机学习环境(Arcade Learning Environment,ALE)数据集所有 57 个雅达利游戏中实现了超越人类的表现。

如果这一说法成立,Agent57 可以为构建更加强大的 AI 决策模型奠定基础。它还能够随着计算量的增加而扩展,训练时间越长,得分也越高。

论文链接:https://arxiv.org/pdf/2003.13350.pdf

57 款雅达利游戏

利用游戏来评估智能体性能是强化学习研究中的一个普遍做法。游戏中的环境是对真实环境的一种模拟,通常来说,智能体在游戏中能够应对的环境越复杂,它在真实环境中的适应能力也会越强。街机学习环境包含 57 款雅达利游戏,可以为强化学习智能体提供各种复杂挑战,因此被视为评估智能体通用能力的理想试验场。

为什么要选择雅达利游戏?原因有以下几点:

1. 足够多样化,可以评估智能体的泛化性能

2. 足够有趣,可以模拟在真实环境中可能遇到的情况;

3. 由一个独立的组织构建,可以避免实验偏见。

在雅达利游戏中,我们希望智能体能够在尽可能多的游戏中表现良好,对当前所处的游戏做出最少的假设,而且不使用特定于某个游戏的信息。

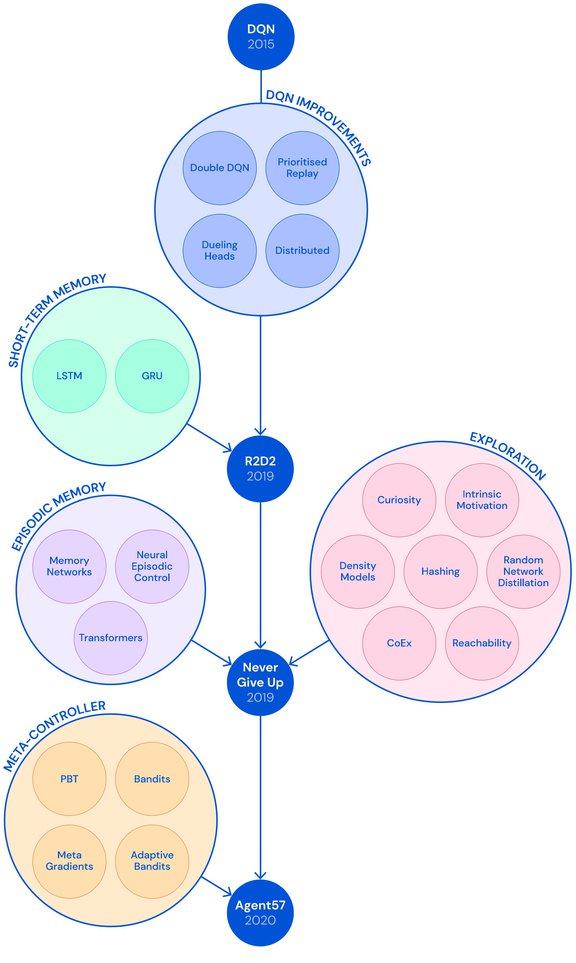

DeepMind 对雅达利游戏的挑战很早就开始了。2012 年,他们创建了 Deep Q-Network(DQN)算法来挑战雅达利的 57 种游戏,此后又经过了多次改进。但遗憾的是,经过改进的 DQN 也始终没有克服四种比较难的游戏:Montezuma's Revenge、Pitfall、Solaris 和 Skiing。此次新发布的 Agent57 改变了这一局面。

DQN 的改进历程(图片来源于 DeepMind 官方博客)

强化学习的挑战

为实现目前的 SOTA 表现,DeepMind 的 Agent57 使用强化学习算法,并同时运行在多台电脑上,这些 AI 赋能的智能体在环境中选择能够最大化奖赏的动作去执行。强化学习在电子游戏领域已经展现出了极大的潜力——OpenAI 的 OpenAI Five 和 DeepMind 的 AlphaStar RL 智能体分别打败了 99.4% 的 Dota 2 玩家和 99.8% 的星际 2 玩家。然而研究人员指出,这并不意味着目前的强化学习方法就无懈可击了。

RL 中存在长期信度分配(credit assignment)问题,也就是根据信度选取最能够产生之后好/坏结果的动作。当奖赏信号具有延迟并且信度分配需要跨越较长动作序列时,以上问题变得尤为困难。另外 RL 还存在探索和灾难性遗忘的问题。智能体在游戏中获得第一个正奖赏之前,可能需要执行上百个动作,并且智能体很容易被困在从随机数据里寻找规律的过程中,或当学习新的信息时突然忘记之前已学到的信息。

NGU(Never Give Up)是一种在两个层面上通过从内部产生固有奖赏来增强奖励信号的技术:在单个 episode 中的短期新颖激励和跨越多个 episode 的长期新颖激励。使用 episodic 记忆,NGU 学会了一系列用于探索和利用(exploring and exploiting)的策略,最终目标是利用习得策略获得游戏的最高得分。

为解决以上问题,DeepMind 团队在 NGU 基础上构建了新的 RL 算法。NGU 的缺陷之一为:其通过不同策略来收集相同数量的经验,而忽略了不同策略在学习过程中的贡献。与之不同的是,DeepMind 的实现将其探索策略贯穿在智能体的整个生命周期中,这使得智能体能够根据其所处的不同游戏有针对性地学习策略。

两种 AI 模型+元控制器:Agent 57实现最佳策略选择

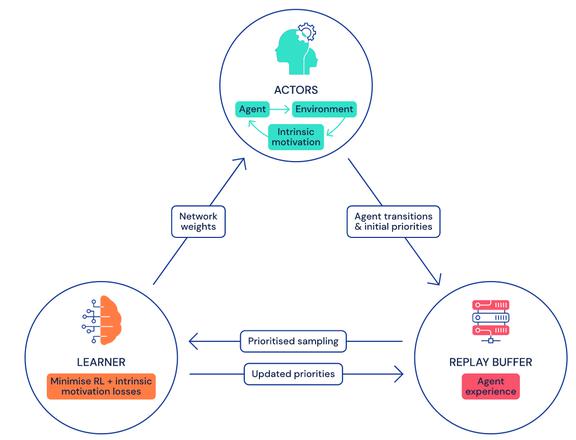

Agent57 总体框架(图片来源于 DeepMind 官方博客)

至于 Agent57 的具体架构,它通过将众多 actor 馈入到学习器可以采样的一个中央存储库(经验回溯缓冲器),进而实现数据收集。该缓冲器包含定期剪枝的过渡序列,它们是在与独立、按优先级排列的游戏环境副本交互的 actor 进程中产生的。

DeepMind 团队使用两种不同的 AI 模型来近似每个状态动作的价值(state-action value),这些价值能够说明智能体利用给定策略来执行特定动作的好坏程度,这样就使得 Agent57 智能体可以适应与奖励相对应的均值与方差。他们还整合了一个可以在每个 actor 上独立运行的元控制器,从而可以在训练和评估时适应性地选择使用哪种策略。

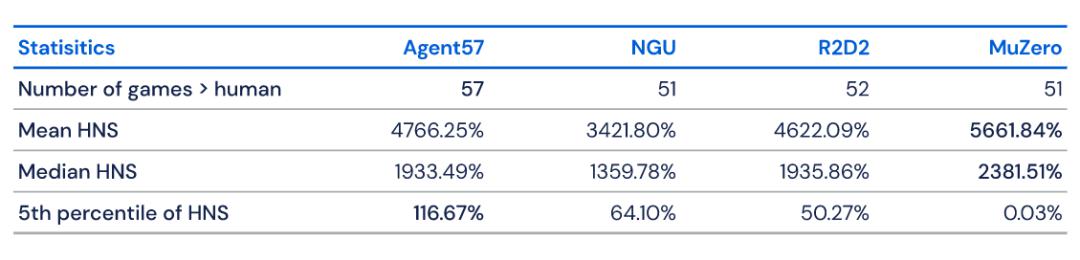

Agent57 与其他算法的性能对比。图源:DeepMind。

研究者表示,这个元控制器具有以下两大优势:其一,得益于训练中的策略优先级选择,它可以使得 Agent57 分配更多的网络容量来更好地表征与手边任务最相关策略的状态行动值函数;其二,它以一种自然的方式在评估时选择最佳策略。

实验结果

为评估 Agent57 的性能,DeepMind 团队将这种算法与 MuZero、R2D2 和 NGU 等领先算法进行了对比。实践可知 MuZero 在全部 57 种游戏中达到了最高平均分(5661.84)和最高中值(2381.51),但也在 Venture 等游戏中表现很差,得分只到和随机策略相当的水平。

实际上,与 R2D2(96.93)和 MuZero(89.92)相比,Agent57 的总体表现上限更高(100),训练 50 亿帧即在 51 种游戏上超越了人类,训练 780 亿帧后在 Skiing 游戏上超越了人类。

随后研究人员分析了使用 meta-controller 的效果。与 R2D2 相比其性能可以提高近 20%,即使在 Solaris 和 Skiing 这种智能体需要收集长时间段信息才能学习所需反馈的长期回报游戏中,也有明显的效果。

谷歌在博客中表示:「Agent57 最终在所有基准测试集最困难的游戏中都超过了人类水平。但这并不意味着 Atari 研究的结束,我们不仅要关注数据效率,也需要关注总体表现……未来的主要改进可能会面向 Agent57 在探索、规划和信度分配上。」

足够惊艳,但有炒作之嫌?

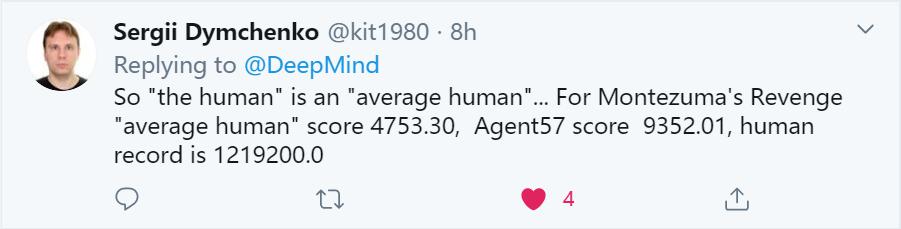

在 DeepMind 推出 Agent57 之后,其宣称在所有雅达利游戏上超越人类的口号吸引了业内人士的关注。但也有网友提出了一些疑问。

下面这位网友对 DeepMind 宣称的「human」提出了质疑,认为 Agent57 超越的只是「average human」。他以《蒙提祖玛的复仇》为例,表示 Agent57 的分数(9352.01)只是超越了「average human」(4753.30),但并未打破人类玩家的记录 1219200.0。

另外,也有人指出了 DeepMind 的研究总是侧重于在雅达利等游戏上的性能表现,应该更多地关注现实世界的实际问题。

不过,人们对于从 DQN 到 Agent57 这一算法改进的「系统树」保持了肯定的态度。这一方向对于强化学习的进步究竟有多大意义,还需要时间来验证。

参考链接:

https://deepmind.com/blog/article/Agent57-Outperforming-the-human-Atari-benchmark

https://venturebeat.com/2020/03/31/deepminds-agent57-beats-humans-at-57-classic-atari-games/

本 文为机器之心报道, 转载请联系本公众号获得授权 。游戏网

责任编辑:

编后语:关于《人类一败涂地?DeepMind推出Agent57,在所有雅达利游戏上超越人类玩家_智能》关于知识就介绍到这里,希望本站内容能让您有所收获,如有疑问可跟帖留言,值班小编第一时间回复。 下一篇内容是有关《王者荣耀:总反向上分?这些英雄只适合开黑,单排千万别冒险》,感兴趣的同学可以点击进去看看。

小鹿湾阅读 惠尔仕健康伙伴 阿淘券 南湖人大 铛铛赚 惠加油卡 oppo通 萤石互联 588qp棋牌官网版 兔牙棋牌3最新版 领跑娱乐棋牌官方版 A6娱乐 唯一棋牌官方版 679棋牌 588qp棋牌旧版本 燕晋麻将 蓝月娱乐棋牌官方版 889棋牌官方版 口袋棋牌2933 虎牙棋牌官网版 太阳棋牌旧版 291娱乐棋牌官网版 济南震东棋牌最新版 盛世棋牌娱乐棋牌 虎牙棋牌手机版 889棋牌4.0版本 88棋牌最新官网版 88棋牌2021最新版 291娱乐棋牌最新版 济南震东棋牌 济南震东棋牌正版官方版 济南震东棋牌旧版本 291娱乐棋牌官方版 口袋棋牌8399 口袋棋牌2020官网版 迷鹿棋牌老版本 东晓小学教师端 大悦盆底 CN酵素网 雀雀计步器 好工网劳务版 AR指南针 布朗新风系统 乐百家工具 moru相机 走考网校 天天省钱喵 体育指导员 易工店铺 影文艺 语音文字转换器