欢迎来到noYes游戏王国

网站导航

在上一篇文章中,小编为您详细介绍了关于《LGD遛狗EDG,iG迷宫图暗示稳赢?LPL春季赛3月31日海报发布》相关知识。本篇中小编将再为您讲解标题每天上千条文本过时,累死志愿者的维基百科被MIT最新AI接手啦!。

原标题:每天上千条文本过时,累死志愿者的维基百科被MIT最新AI接手啦!

大数据文摘出品

来源:MIT

编译:Iris、钱天培

维基百科作为一个开放协同式的百科网站,是全世界最受欢迎的十大网站之一。目前,维基百科已经累积了超过上百万个词条。

由于事实发生变更,每天有千上万的文章需要及时更新。编辑工作涉及文章扩展、重大改写,或诸如更新数据、日期、人名和地点等例行修订。现在,这项任务由世界各地的志愿者维护着。

幸运的是,MIT的一项最新研究成果有望大大减轻志愿者的维护压力。

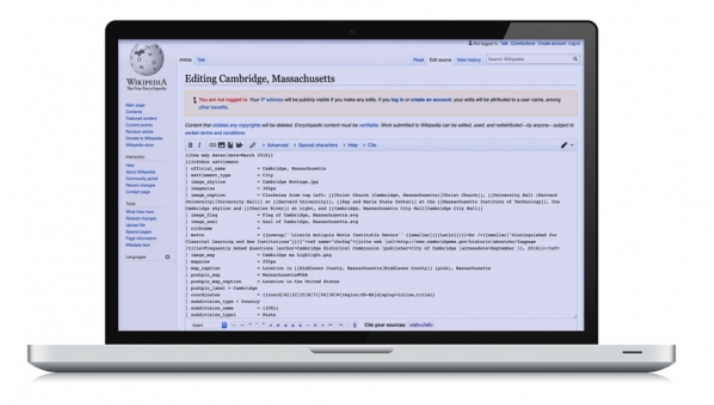

在今年AAAI人工智能大会上,MIT的几位研究者提出了一个文本生成系统,该系统能精确定位维基百科句子,还能用近似人类的编写方式替换句子中特定的信息。

人们只需要在某个界面输入简短的语句,指出信息变更,这一系统就能自动检索维基百科,定位到具体的页面和过时的语句,再以人类的方式重写该语句。

研究者也提到,未来可以构建一个全自动化的系统,通过识别和运用网络上最新的信息来生成维基百科语句需要重写的句子。

论文合著者之一的Darsh Shah,一位来自计算机科学与人工智能实验室(CSAIL)的博士生表示,“维基百科的文章一直都有大量的更新工作,如果能减少或没有人工干预的情况下,实现自动、准确地修订文章,那会非常有价值。不再需要耗费大量人力来修订维基百科的文章,只需几个人便即可搞定,因为模型可以自动完成,这是巨大的提升。

事实上,已经有许多其他的机器人能自动编辑维基百科。Shah提到,这些工具一般被用来减少破坏性信息,或是去除预定义模板的狭义界定信息。

他指出,他们的新模型解决了人工智能的一个棘手问题:给定一个新的非结构化信息,模型会像人一样自动修订语句。

“其他的机器人更多采用基于规则的方法,然而自动修订则是要能够判别两个句子中矛盾的部分,并生成连贯的文本。”

论文合著者和CSAIL研究生Tal Schuster提到,系统还可以使用其他的文本生成应用。论文中,研究者使用流行的事实核查数据集自动合成语句,来减少偏差,也无需人工收集额外的数据。Schuster表示这种方式可以改善自动化事实核查模型,比如,训练数据集检测虚假新闻。

Shah、Schuster、德尔塔电子电气工程与计算机科学Regina Barzilay教授以及CSAIL的一位教授一起合著了这篇论文。

“中立屏蔽”

依托一系列的文本生成技术,系统得以识别句子的矛盾信息,并将两个独立的句子融合在一起。将维基百科文章中“过时”句子和“声明”句子作为输入,声明句子包含了更新和冲突信息。系统会依据声明句子自动删除和保留过时句子中的特定词,并在不改变样式和语法情况下更新句子的事实。这对人来说很容易,但对机器学习而言具备挑战。

举例来说,如果要将“费德勒有19个大满贯”更新为“费德勒有20个大满贯”。依据声明句子,在维基百科找到“费德勒”,将过时数据(19)替换为新数据(20),并保留句子原有的句式和语法。在他们的工作中,研究者只用到维基百科部分句子的数据集来运行该系统,而无需访问百科所有的页面。

系统采用包含句子对的流行数据集来进行训练,每个句子对包含一个声明和另一个相关的维基百科句子。每个句子对会被标记为三种状态:同意、不同意、中立。

“同意”代表句子之间包含的事实信息一致。“不同意”代表两个句子之间存在矛盾的信息。“中立”代表没有足够的信息来判别是否同意。系统依据声明改写过时句子之后,所有标记为不同意的句子将变为同意状态。这需要两个独立的模型来得到期望的结果。

一个模型是事实核查分类器,预训练的时候需将每个句子标识为“同意”、“不同意”、“中立”,主要用于找出存在矛盾的句子对。

与分类器一起运行的还有一个自定义的“中立屏蔽”(neutrality masker)模块,用以鉴别过时句子中哪些单词与声明句子相矛盾。该模块删除尽可能少的单词以达到“最大化中性”,即句子可以被标记为中性。

也就是说,如果把这些词屏蔽后,两个句子将不再存在矛盾信息。我们对过时语句构建了一个二进制的“遮蔽”模块,0代表可能需要删除的单词,1代表同意保留的单词。

遮蔽后,我们使用一个“双编码—解码”框架(two-encoder-decoder framework)生成最终的输出句子。模型会学习声明句子和过时句子的特征。与此同时,采用“双编码—解码”过程来融合声明中相矛盾的单词:先删除过时句子中包含矛盾信息的单词(即被标记为0的单词),而后填补更新过的单词。

在一项测试中,模型的测试结果超越了所有传统方法,测试使用一种名为“SARI”的方法比对机器删除、增加和保留句子与人类修订语句的差异。

与传统文本生成方法相比较,新模型能更准确地更新事实信息,输出句子更加接近人类编写的结果。

在另一项测试中,众包人员对模型生成的句子进行打分,主要是对事实更新准确性和语法匹配程度来打分,分值区间为1到5分。模型“事实更新”的平均得分为4分,“语法匹配度”的平均得分为3.85分。

数据增强,消除偏差

研究也表明,该系统可以用增强数据集来训练“虚假新闻”鉴别器,起到消除训练偏差的作用。

“虚假新闻”用虚假信息的宣传形式来误导读者,从而获取更多的网络浏览和引发公众舆论。

判断虚假信息的模型通常需要很多“同意-不同意”的句子对作为数据集。

在这些句子对里,声明要么包含与维基百科给定的“证据”句子相匹配(同意)的信息,要么包含由人工修订后与证据句子相矛盾的信息(不同意)。模型经过训练可以将与“证据”相矛盾的句子标记为“错误”,从而鉴别虚假信息。

不幸的是,Shah认为这些数据集势必存在偏差。“在训练期间,在缺少足够相关‘证据’语句的情况下,虚假信息中的某些短语也会让模型轻易发现‘漏洞’。在评估真实语句实例的时候,这会降低模型的准确性,没法起到有效的核查作用。”

研究者在维基百科项目中使用了同样的删除和融合技术来平衡数据集中的“不同意-同意”对,以缓解偏差。对一些“不同意”句子对,他们使用修正语句中的错误信息来为句子重新生成一个假的“证据”。若揭示性短语在“同意”和“不同意”句子中都存在,模型就能够辨别更多的特征。使用增强后的数据集,研究将虚假鉴别器的错误率减少了13%。

Shan强调,“如果在你的数据集中存在偏差,那么模型往往会失真。因此,数据增强非常有必要。”

相关报道:

https://www.csail.mit.edu/news/automated-system-can-rewrite-outdated-sentences-wikipedia-articles游戏网

编后语:关于《每天上千条文本过时,累死志愿者的维基百科被MIT最新AI接手啦!》关于知识就介绍到这里,希望本站内容能让您有所收获,如有疑问可跟帖留言,值班小编第一时间回复。 下一篇内容是有关《阿里鱼拓展IP合作新边界助力首钢体育天猫旗舰店喜迎开门红》,感兴趣的同学可以点击进去看看。

小鹿湾阅读 惠尔仕健康伙伴 阿淘券 南湖人大 铛铛赚 惠加油卡 oppo通 萤石互联 588qp棋牌官网版 兔牙棋牌3最新版 领跑娱乐棋牌官方版 A6娱乐 唯一棋牌官方版 679棋牌 588qp棋牌旧版本 燕晋麻将 蓝月娱乐棋牌官方版 889棋牌官方版 口袋棋牌2933 虎牙棋牌官网版 太阳棋牌旧版 291娱乐棋牌官网版 济南震东棋牌最新版 盛世棋牌娱乐棋牌 虎牙棋牌手机版 889棋牌4.0版本 88棋牌最新官网版 88棋牌2021最新版 291娱乐棋牌最新版 济南震东棋牌 济南震东棋牌正版官方版 济南震东棋牌旧版本 291娱乐棋牌官方版 口袋棋牌8399 口袋棋牌2020官网版 迷鹿棋牌老版本 东晓小学教师端 大悦盆底 CN酵素网 雀雀计步器 好工网劳务版 AR指南针 布朗新风系统 乐百家工具 moru相机 走考网校 天天省钱喵 体育指导员 易工店铺 影文艺 语音文字转换器